|

NASCE IL PRIMO COMPUTER: ...quando

Colossus |

|

SCHEDA |

COMPUTER |

|

NASCE IL PRIMO COMPUTER: ...quando

Colossus |

Probabilmente non si potr� mai sapere con esattezza quando l'uomo si rese conto di poter effettuare dei calcoli e, soprattutto, di essere in grado di farlo attraverso l'uso di uno strumento o di un utensile. Le prove di una simile capacit� arrivano al 30.000 a.C., visto che risale a quest'epoca un osso di lupo, ritrovato ai giorni nostri, impiegato come base di calcolo, sul quale sono state incise 55 tacche a gruppi di cinque, forse per uno scambio o un baratto. Questa capacit� di esplorare e sistematizzare l'universo dei numeri, primo passo per il dominio dei dati e delle informazioni, si perde indubbiamente nella notte dei tempi e ha sempre rappresentato per l'uomo una sfida affascinante e stimolante, portata avanti nei secoli, pur con le inevitabili e conseguenti limitazioni della tecnologia del proprio tempo. Solo nel nostro secolo, e pi� precisamente a partire dagli anni Cinquanta, si � affermata quella capacit� intuitiva e scientifica in grado di portare alla nascita dello strumento pi� adatto e pi� aderente al concetto stesso di calcolo in tutti i suoi pi� vari aspetti: il computer. Il suo stesso nome, infatti, chiarisce le sue prerogative.

"Computer" deriva dal verbo latino "computare", che significa "fare di conto".

(A dargli questo nome fu Anatasoff Berry, un rumeno. E' lui considerato il "padre" del Computer - VEDI - Ndr.) Potr� sembrare strano, o risulter� presumibilmente misconosciuto, ma i "personal computer", i famosi "Pc" che utilizziamo quotidianamente nel nostro lavoro o come passatempo, sono il risultato attuale, e allo stesso tempo parziale, di un processo che ha avuto inizio esattamente nel 1642, anno nel quale il filosofo francese Blaise Pascal costru� la prima calcolatrice meccanica con riporto automatico fino ad otto cifre. La ide� per aiutare il padre, esattore delle tasse a Rouen. Certo, anche precedentemente l'ingegno di alcuni uomini di scienza era riuscito a costruire macchine per il calcolo (come quella del matematico e astronomo tedesco Wilhelm Schickart, che nel 1623 invent� un "orologio calcolatore", capace di eseguire le quattro operazioni e la radice quadrata). Ma si trattava di esemplari unici, strumenti che dimostravano esclusivamente in linea teorica la capacit� di effettuare calcoli senza l'ausilio della mente umana. Ma � appunto con Pascal e, pochi anni dopo, con il filosofo e matematico tedesco Gottfried Wilhelm von Leibniz, ideatore di una calcolatrice a ruote dentate in grado di eseguire operazioni pi� complesse, che prende avvio quel "sentiero" tecnologico e scientifico che porter� alla nascita e allo sviluppo di quella che noi chiamiamo usualmente "informatica", cio� la scienza che studia l'elaborazione dei dati e, pi� generalmente, il trattamento automatico delle informazioni.

Una scienza estremamente giovane, visto che il termine � stato formulato per la prima volta nel 1962 dall'ingegnere francese Philippe Dreyfus, contraendo le parole "information" e "automatique". I primi passi, di quella che possiamo definire la "storia del computer", possono essere datati al 1925, quando il professor Vannevar Bush ed altri docenti del Massachusetts Institute of Technology (il celeberrimo MIT) progettarono il "Differential Analyzer", il primo calcolatore meccanico di uso pratico. Fu indubbiamente questa la prima macchina che poteva vantare, in modo assai improprio, il termine di "computer" . Entrata in funzione due anni pi� tardi, il "Differential Analyzer" fu in grado di risolvere automaticamente equazioni differenziali contenenti fino a 18 variabili indipendenti.

La macchina era costituita da un insieme di valvole termoioniche e da parti elettromeccaniche e venne prodotta in una decina di esemplari. Uno di questi fu acquistato dai militari americani che lo utilizzarono fino all'inizio degli anni Cinquanta per calcoli balistici. Ovviamente il fatto di considerare tale apparecchio un prototipo dei nostri " computer" non deve trarre in inganno: si trattava di una grossa scatola in legno, dalle dimensioni ancora contenute, che poteva essere programmato in alcuni giorni. Proprio cos�. Noi siamo abituati a programmare quotidianamente i nostri "Pc" attraverso i tantissimi "softwares" a disposizione nel giro di pochissimi minuti. A quei tempi, invece, i programmatori impiegavano giorni, se non addirittura settimane a programmare il "Differential Analyzer" e gli altri strumenti elettromeccanici dell'epoca. Un'altra grossa novit�, risalente sempre agli anni Venti, fu quella della scheda perforata. Questo rettangolo di carta dura, composto da 45 a 80 colonne di numeri e lettere, veniva perforato e introdotto in speciali macchinari, chiamati calcolatori meccanografici, per effettuare diversi tipi di calcoli.

La potenza di questi calcolatori era data da due capacit�: la velocit� di lettura delle schede e il numero di schede che potevano essere "lette" in un minuto. Le apparecchiature pi� veloci potevano arrivare a 2.500 schede al minuto. Per impedire possibili malfunzionamenti delle macchine per via di inevitabili deformazioni delle schede, queste ultime vennero fabbricate dalle cartiere incaricate con rigorosissimi criteri che arrivarono al punto di disporre le fibre di cellulosa nella senso della lunghezza, per evitare inceppamenti ed errori di lettura. Ma nessuna di queste macchine, fino ad allora, aveva utilizzato quel tipo di codice divenuto universale per coloro che si occupano di informatica. Questo codice, che ognuno di noi ha studiato a scuola, si chiama "sistema binario" e si basa unicamente su due numeri: lo 0 e l'1. Furono i cinesi a inventarlo nel 1100 a.C., come scrisse Wong Sang, vissuto tra il 1182 e il 1135 a.C., nel suo " Libro delle permutazioni" .

E fu nel 1936 che il tedesco KONRAD ZUSE, giovane docente all'Istituto di Matematica dell'universit� di Saarbrucken, realizz� nel salotto di casa dei suoi genitori la "Z1", la prima macchina elettromeccanica (a rel�) sperimentale per l'elaborazione dei dati, controllata da un programma su nastro perforato. Come nastro utilizz� una vecchia pellicola cinematografica e, aspetto fondamentale, fu il primo ad impiegare il sistema numerico binario. Ma fu in quegli stessi anni che oper� un genio destinato a rivoluzionare il concetto stesso di macchina calcolatrice con tutti i suoi sbocchi per l'avvento del "computer" .

Questo uomo geniale, uomo-simbolo della futura informatica come Albert Einstein lo fu per la fisica, fu il matematico inglese di origine ungherese Alan Mathison Turing, nato nel 1912 e morto suicida nel 1954. Nel 1936, Turing present� un suo studio riguardante una macchina calcolatrice astratta di uso generale per la soluzione di tutti i problemi matematici. La teoria del brillante matematico inglese era quella di costruire una macchina in grado di leggere un nastro continuo suddiviso in due parti: il calcolatore avrebbe dovuto leggere le istruzioni della prima parte, le avrebbe subito eseguite e poi sarebbe passato alla seconda parte del nastro. Questo metodo di impostazione della macchina, detta di Turing, convinse molti specialisti sulla possibilit� di creare una vera e propria "intelligenza artificiale". Non solo, ma diversi storici sono convinti che furono proprio le straordinarie intuizioni scientifiche e matematiche di Turing che permisero agli Alleati di vincere la Seconda guerra mondiale."COLOSSUS" contro "ENIGMA"

Durante il conflitto, infatti, diversi specialisti americani e inglesi, diretti da Turing con la piena approvazione di Churchill, riuscirono a decrittare i messaggi tedeschi codificati con "Enigma", la macchina crittografica realizzata nel 1923 dal berlinese Arthur Scherbius. Questo apparecchio, che funzionava con una pila elettrica e un sistema di tamburi rotanti e commutatori elettrici, permise ai nazisti di trasmettere messaggi praticamente indecifrabili nella primissima parte della guerra. Gli analisti tedeschi erano convinti che per decifrare uno dei 15.576 codici sarebbe occorso a un gruppo di matematici almeno un mese di tempo. Per questo motivo, Churchill incaric� Turing di organizzare e dirigere il centro sulla comunicazione cifrata di Bletchley Park, nel Buckinghamshire, formato da centinaia di menti brillanti e originali.

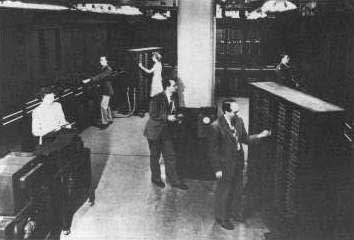

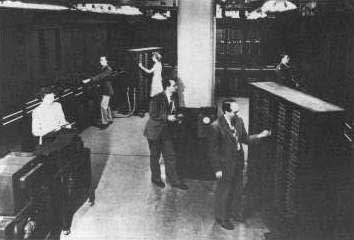

Tale gruppo, che raggiunse nel 1944 circa settemila persone, era composto da civili e militari, archeologi e uomini d'affari, giornalisti e cartografi, linguisti e geni della matematica, crittografi e musicisti, enigmisti e diplomatici, esperti navali e scacchisti, giocatori d'azzardo ed eminenti docenti di Oxford e Cambridge. Per svelare i segreti di "Enigma" Turing e T. H. Flowers, un esperto di centralini telefonici, realizzarono "Colossus", il primo calcolatore elettromeccanico britannico impiegato per provare ad enorme velocit� tutte le possibili combinazioni dei codici della macchina crittografica nazista. Proprio la decrittazione del codice di "Enigma" cost� alla marina italiana tre incrociatori pesanti e due cacciatorpediniere nella battaglia di Capo Matapan del 28 marzo 1941. Questo perch� gli inglesi seppero fin dall'inizio le strategie e i movimenti della nostra flotta.

"Colossus" era fornito di 1.500 valvole e pesava pi� di una tonnellata. Non aveva memoria e non poteva essere programmato. Eppure, era in grado di trattare 5.000 caratteri al secondo e di decifrare ogni giorno, dopo avere scardinato il sistema crittografato di "Enigma", pi� di 4.000 messaggi segreti tedeschi e altrettanti giapponesi e italiani. Churchill, per�, non si rese conto fino in fondo delle enormi possibilit� date dai calcolatori e dalle teorie di Turing. Dopo la guerra, ordin� di smontare e distruggere tutti i modelli di "Colossus" utilizzati per sconfiggere i nazisti. Turing continu� a dedicarsi allo studio dell'intelligenza artificiale e all'ideazione di nuovi calcolatori elettronici.

Ipersensibile, incompreso, circondato dal scetticismo e dall'ostilit� dell'ambiente scientifico, il matematico inglese si suicid� il 7 giugno 1954, mangiando una mela al cianuro, per motivi mai chiariti. Due anni prima era stato coinvolto in uno scandalo per una relazione omosessuale (all'epoca considerata un reato in Gran Bretagna) e condannato a seguire una terapia ormonale che lo aveva reso impotente. Gli anni del dopoguerra, comunque, fecero registrare un balzo in avanti nella progettazione e nella costruzione dei calcolatori. Furono gli anni in cui dominarono i "dinosauri", per via del loro peso e delle loro dimensioni. Come nel caso di "Bessie", il calcolatore elettromeccanico "Harvard Mark 1", realizzato nei laboratori IBM da Howard Aiken con la collaborazione di alcuni esperti e ricercatori dell'universit� di Harvard.

"Bessie", cos� era stato soprannominato questo colosso, pesava cinque tonnellate, aveva 800 chilometri di cavi e pi� di tremila "rel�", per un totale di 76 mila componenti. Lungo 16 metri e mezzo e alto due e mezzo, l'"Harvard Mark 1" fu il primo calcolatore a funzionare automaticamente con programmi registrati, gli "antenati" degli odierni "softwares" . Questa macchina era in grado di sommare due numeri di ventitr� cifre in tre decimi di secondo e moltiplicarli in soli sei secondi. Se consideriamo che queste stesse operazioni sono effettuate oggigiorno da semplicissime calcolatrici da taschino in un tempo pi� breve, possiamo benissimo capire cosa � stato fatto in meno di cinquant'anni. "Bessie" venne impiegata dalla Marina militare statunitense per studi di balistica e progettazione di navi e dalla Commissione per l'energia atomica per ricerche sulla disintegrazione dell'atomo.

Una curiosit�: fu proprio con questo calcolatore che venne coniato il termine di "bug", in seguito usato dagli specialisti e appassionati di informatica per definire un errore di programmazione in un "software".

Il fatto prende spunto da un divertente episodio: dopo un improvviso blocco della macchina, la matematica Grace Murray Hopper impieg� diverse ore per comprendere l'origine del guasto. Alla fine scopr� che uno scarafaggio si era annidato in un rel�, bloccando il funzionamento di "Bessie". Ma questo calcolatore, seppure dotato di misure ragguardevoli, pu� essere considerato piccolo davanti alle dimensioni del gigantesco elaboratore elettronico "Eniac", acronimo di "Electronic Numerical Integrator and Calculator" . Questo mastodonte entr� in funzione il 16 febbraio1946 in un salone di nove metri per quindici, al poligono di tiro del comando di artiglieria di Aberdeen, nel Maryland.

Ecco alcune sue caratteristiche: aveva quasi 17 mila valvole, 70 mila resistenze e 10 mila condensatori, 5 mila saldature e un peso di trenta tonnellate. Era capace di effettuare 300 moltiplicazioni o 5.000 addizioni al secondo e assorbiva la bellezza di 174 Kilowatt quando era in funzione, con il risultato di fare fondere continuamente, per via del terribile calore, gli isolanti dei diversi condensatori. Questo vero e proprio colosso, ma delicato come una fragile lampadina, venne costruito per conto dell'Esercito americano, pi� precisamente per il laboratorio ricerche balistiche. Originariamente doveva costare 150.000 dollari, alla fine, per�, il suo costo arriv� alla stratosferica cifra di quasi mezzo milione di dollari, una somma altissima per un solo elaboratore. Ma spesa a parte (a carico dei contribuenti, ovviamente), l'"Eniac" era considerato utilissimo nei vertici dell'Esercito americano.

Questo perch� le tabelle balistiche, indispensabili per ogni tipo di cannone e proiettile, erano necessarie ai soldati statunitensi poich�, dopo la campagna di guerra del Nord Africa nel 1942, gli Alleati avevano capito che, a causa delle differenti caratteristiche e peculiarit� del terreno, cos� diverso rispetto a quello americano, i tiri dell'artiglieria risultavano assai imprecisi. Allo stesso tempo, per�, ricalcolare a mano tutte le precedenti tabelle era un'impresa a dir poco impossibile. Tanto per fare un esempio, per stilare una semplice tabella balistica occorreva calcolare dalle duemila alle quattromila traiettorie, ognuna delle quali richiedeva all'incirca 750 moltiplicazioni. Ecco perch� il contributo di "Eniac" fu importantissimo, in quanto fu capace di calcolare una determinata traiettoria in appena 30 secondi contro le quasi venti ore necessarie a un matematico con l'ausilio di una calcolatrice elettromeccanica.

Considerato una meraviglia del suo tempo, questo gigante rimase in servizio per nove anni, fino a quando divenne praticamente impossibile usarlo a causa dei continui guasti e per le enormi spese di manutenzione (una squadra di dieci tecnici era sempre disponibile ventiquattro ore al giorno). Dato l'enorme calore sprigionato e la fragilit� dei suoi componenti, l'"Eniac" si guastava in media ogni cinque ore e mezza e in un anno era capace di bruciare quasi 20 mila valvole. Ma oltre alle sue incredibili dimensioni e per il fatto di essere considerato il primo vero "prototipo" di "computer", l'"Eniac" merita di essere ricordato anche per un altro fatto.

Durante la sua costruzione, lo scienziato John Tykey cre� il termine di "bit", attraverso la contrazione delle parole inglesi "Binary digit" (cifra binaria). Un "bit" � la pi� piccola unit� di informazione che specifica uno dei due stati (0 o 1, acceso o spento) che codificano i dati all'interno dei computer. Una striscia di otto "bit" forma un "byte", oggi universalmente utilizzato per rappresentare un carattere o un numero singolo. Questo per dare un'idea del numero di calcoli che vengono effettuati da un comune computer dei nostri giorni (nell'ordine di diversi miliardi al secondo) per eseguire i tanti programmi o "softwares", rispetto alle prestazioni del povero "Eniac". Ma per proseguire nel famoso "sentiero" che abbiamo ricordato all'inizio c'era bisogno di una grande invenzione, capace di fare progredire ulteriormente l'avvento delle macchine calcolatrici. Questa invenzione, la prima di una lunga serie, si chiama "Transistor". Furono tre ricercatori americani, John Bardeen, Walter Houser Brattain e William Bradford Shockley a idearlo e a perfezionarlo il 23 dicembre 1947. Questo termine rappresenta la contrazione di "TRANsfer reSISTOR", in quanto � in grado di far variare la resistenza tra due morsetti agendo dall'esterno. In pratica il "Transistor" subentr� alle fragili e costose valvole di vetro utilizzate nelle apparecchiature radio e, nel nostro caso, dai calcolatori.

I punti a suo favore erano diversi: praticamente indistruttibile grazie a una durata di 90 mila ore, pi� piccolo, qualche millimetro contro i diversi centimetri delle valvole "miniaturizzate", meno "affamato" di elettricit� e con la possibilit� di funzionare subito senza attendere il suo riscaldamento, a differenza delle stesse valvole. Ma si dovette attendere fino al 1950 per vedere il primo elaboratore elettronico costruito in serie. Si trattava dell'"Univac-1" con un costo assolutamente proibitivo, 250 mila dollari dell'epoca. Anche l'"Univac-1" in fatto di misure non scherzava: pesante cinque tonnellate, l'unit� centrale occupava uno spazio di 5 metri e mezzo per quasi quattro ed era alto due metri e mezzo. Funzionava ancora a valvole, ne aveva 5.400 miniaturizzate. Troppo grande e soprattutto troppo costoso per essere alla portata di tutti. Ma ormai l'epoca delle valvole era giunta al tramonto. Si stava per profilare quella che gli storici e gli specialisti di informatica hanno chiamato la "seconda generazione" dei computer, tutti con transistor, pi� piccoli e molto pi� potenti. Una generazione che fece finalmente i conti con il problema, fino a quel momento irrisolto, della "memoria". Fu tra il 1950 e il 1955 che gli elaboratori dell'epoca vennero dotati di "memorie" interne, basate su valvole, tubi catodici e tamburi magnetici, fino agli anelli di ferrite. Ma si trattava ancora di processi a dir poco antidiluviani. Basti pensare che ogni valvola poteva memorizzare esclusivamente un "bit" e che, come si � gi� ricordato, tali valvole potevano avere solo poche ore di funzionamento. Il problema era dunque quello di immagazzinare dati e informazioni senza il rischio di perderle da un momento all'altro. Dapprima vennero impiegate linee di ritardo acustico costituite da cilindri di acqua o di mercurio con alle estremit� due cristalli piezoelettrici di quarzo.

Un impulso, che giungeva da uno dei cristalli, veniva trasformato in vibrazione meccanica, trasmessa come vibrazione acustica attraverso il mercurio all'altro cristallo e da questo trasformato in impulso elettrico. In questo modo, il segnale giungeva ritardato per permettere al segnale acustico di attraversare il fluido: ci� dava la possibilit� di trasmettere mille segnali al secondo e memorizzare, quindi, mille segnali binari che, con il procedimento inverso, potevano essere "letti" e "riletti" a piacere. Dalle linee di ritardo si pass� ai tamburi in alluminio o bronzo ricoperti di vernice magnetica che ruotavano ad alta velocit�. Una serie di puntine magnetiche scriveva i dati sulla superficie cilindrica del tamburo in forma di punti magnetizzati e li leggeva poi con un tempo di accesso veramente notevole: da cinque a venticinque millesimi di secondo. Questo sistema permetteva di memorizzare fino a un milione di caratteri. Un bel passo in avanti, indubbiamente, ma ancora insufficiente per registrare e conservare una grande mole di informazioni, senza contare che tali "memorie" occupavano uno spazio enorme all'interno della macchina. Cos� si decise di puntare soprattutto sulle "memorie" ausiliarie esterne, nastri e dischi magnetici, in grado di essere introdotti al momento dell'uso per essere poi rimossi e conservati altrove. I nastri erano composti da fettucce di plastica ricoperte di ossido metallico sulle quali le informazioni venivano memorizzate in forma di punti magnetizzati per rappresentare i simboli 1 e 0 del linguaggio binario.

I dati venivano registrati e letti da una testina magnetica; il nastro scorreva a una velocit� di due metri al secondo, equivalenti a 15 mila caratteri, quasi 50 volte superiore alle schede perforate. Le prime bobine erano grandi come torte e potevano registrare alcuni milioni di caratteri. Entrati nella seconda met� degli anni Cinquanta, tutte le industrie e i maggiori specialisti di elaboratori furono concordi nel ritenere che il futuro sarebbe stato riservato a macchine pi� piccole e potenti. La prima ad inaugurare questa tendenza fu un "minielaboratore" prodotto dalla Digital Equipment Corporation nel 1957, il PDP-1, del costo di 159 mila dollari, il quale diede lo spunto per il modello successivo, il PDP-8, grande poco pi� di un frigorifero e con una memoria di appena 4 Kbyte, messo in vendita alla cifra di 18 mila dollari. Di questo tipo vennero venduti 50 mila esemplari. Fu il primo vero fenomeno di massa per quello che riguarda il mondo dei "computer", ma che non spinger� i vertici dell'azienda a proseguire oltre. Uno dei progettisti di questa macchina, l'ingegnere Kenneth Olsen, non pens� mai che i "computer" avrebbero dato una svolta alla nostra vita quotidiana. Ancora nel 1977, dichiar� risolutamente: "Non vedo proprio perch� una persona dovrebbe tenersi in casa un computer". Parole per cos� dire "profetiche", visto che nel frattempo le invenzioni tecnologiche stavano spianando la strada alla continua evoluzione dei "computer". Nel 1958, l'ingegnere americano Jack St. Clair Kilby, della Texas Instruments di Dallas, rimase a lavorare in estate mentre i colleghi erano in ferie. Lui era stato appena assunto e non aveva dunque diritto alle vacanze. Fu una fortuna per lui e, soprattutto, per tutti noi, dato che in quelle settimane Kilby schiuse l'era della miniaturizzazione dei circuiti elettrici con l'invenzione del cosiddetto "circuito integrato", familiarmente conosciuto con il termine di "chip".

Per la prima volta, l'ingegnere statunitense riusc� a combinare le funzioni di bobine, transistor, diodi, condensatori e resistori in una unit�, completa dei relativi collegamenti, realizzata su una piastrina di materiale semiconduttore, il silicio cristallino, di proporzioni minime. Proprio l'invenzione del "chip" diede modo di ideare e costruire schede con centinaia di "circuiti integrali", capaci di svolgere nello spazio di poche decine di centimetri le stesse operazioni che, fino a poco tempo prima, erano effettuate da macchinari di diversi metri e tonnellate. E' chiaro che queste spinte tecnologiche permisero alle grandi aziende (e non pi� solo ai militari) di beneficiare degli sviluppi e della velocizzazione del lavoro. Sempre nel 1958, in America erano in funzione 2.500 elaboratori elettronici, mentre in Italia erano quaranta. Proprio nello stesso anno, il Banco di Roma (la futura Banca di Roma) fu il primo istituto di credito in Europa ad installare un elaboratore IBM di grande potenza per lo svolgimento di tutte le operazioni contabili, statistiche e di controllo degli oltre suoi 200 sportelli. L'anno dopo a Milano, in occasione della Fiera, la Olivetti present� il primo calcolatore elettronico a transistor di progettazione interamente italiana: l'"Elea 93". Questa macchina, ancora di grosse dimensioni, aveva 10 mila transistor e disponeva di una stampante capace di scrivere 600 righe al minuto. Fu un grosso successo commerciale, visto che ne furono consegnati oltre 12 mila esemplari in tutto il mondo.

Ma se in Italia si era ancora alle prese con macchinari di grandi dimensioni, in America, all'inizio degli anni Sessanta, si lavorava sempre pi� al concetto di riduzione della macchina e del suo aumento di potenza. Il 1963 � un anno da ricordare perch� in quella data un gruppo di ricercatori, guidato da Douglas Englebart, dello Stanford Research Institute, svilupp� per la prima volta il famoso "mouse", il dispositivo di puntamento rapido del cursore sullo schermo. Ma bisogner� attendere ancora vent'anni prima di vederlo in produzione. L'anno successivo, la IBM mise in vendita il primo programma di "Word processor" (elaboratore di testi) del mondo e l'anno dopo il colosso americano lanci� sul mercato un nuovo elaboratore della cosiddetta "terza generazione", l'"IBM Sistema/360" a circuiti integrati con una memoria fino a quattro milioni di caratteri.

La novit� stava nel fatto che questo tipo di macchina poteva essere potenziata, aumentando la capacit� della stessa memoria, o addirittura ingrandito con altri elementi. Il progettista fu Gene Amdahl, il primo a fare funzionare una macchina alla velocit� di "nanosecondi" (miliardesimi di secondo). Il "Sistema/360" fu per anni il computer pi� venduto al mondo (nel 1966 le vendite arrivarono a mille esemplari al mese). Ma nel 1965 fu sempre la Olivetti di Ivrea a fregiarsi di un primato assoluto: a New York present� il famoso "Programma 101", il primo personal computer del mondo prodotto in serie, destando sensazione per le sue prestazioni elevate, le dimensioni ridotte e l'elegante "design" di Mario Bellini. In pochi anni furono venduti quasi 45 mila esemplari grazie alla sua semplicit� di uso. Il "P101" fu la prima macchina dotata di un programma registrato in memoria, di un supporto magnetico per l'introduzione e l'uscita dei dati (dal quale avr� poi origine il "floppy disc") e di un semplice sistema di programmazione con un linguaggio che poteva essere appreso in poche ore anche da non specialisti.

Il suo costo, sempre altissimo, era di due milioni di lire. La supremazia americana, per�, torn� a farsi sentire nel 1968, quando Robert N. Noyce, Gordon E. Moore e Andrew Grove si unirono per dare vita alla Intel Inc. (cos� denominata da INTegrated ELectronics) per la produzione di "chip" di memoria. Nel suo primo anno, ebbe dodici dipendenti e un fatturato di 2.600 dollari. Oggi � l'indiscusso colosso costruttore di microprocessori (i famosi Pentium II e III) con fatturati di diversi miliardi di dollari. Proprio l'Intel, nel 1970, produsse la prima RAM ("Random Access Memory" ), la memoria a semiconduttori da 1 Kbyte, che fu adottata immediatamente nella costruzione di nuovi computer al posto delle vecchie memorie a nuclei magnetici di ferrite. Il 1971 fu un altro anno importantissimo per la storia dei computer, quando gli ingegneri elettronici della Intel, l'italiano Federico Faggin e gli americani Marcian Edward Hoff jr. e Stanley Mazer, diedero vita al "motore" dei futuri "Pc", il microprocessore. I tre riuscirono a concentrare su una piastrina di quattro millimetri per tre un "supercircuito integrato" contenente ben 2.250 transistor, la futura CPU ("Central Processing Unit" ) che costituivano tutti i componenti di un'unit� centrale di elaborazione: in breve, il "cervello" e la "memoria" di entrata e uscita. L'anno successivo, sempre Faggin e Hoff jr. realizzarono il microprocessore "8008", il primo "chip" da 8 bit di uso universale.

Questa CPU, con una memoria statica da 1.024 byte, era in grado di conservare i dati sino a quando non veniva interrotta l'alimentazione elettrica nel sistema. Su questo processore, gli ingegneri Nat Wadsworth e Robert Findley realizzarono il primo "microcomputer " che venne prodotto in serie con una scatola di montaggio dalla Scelbi Computer Consulting di Milford (Connecticut), con il nome di "Scelbi-8H" e messo in vendita per corrispondenza nel 1974 a 440 dollari. Mancava solo un altro componente per assicurare la completa autonomia ai nuovi modelli di "computer" che continuavano ad essere ideati e progettati: la "memoria" dove conservare i dati e le informazioni anche con l'apparecchio spento. Questo ostacolo venne superato definitivamente con l'uscita dell'"IBM 3340" che adottava la tecnologia di memoria su "hard disk" (disco rigido); quattro dischi in alluminio magnetizzati su entrambe le facce, sistemati uno sull'altro in un contenitore sigillato, venivano letti e registrati da una serie di testine velocissime che si insinuavano tra i dischi, sfiorandone le superfici a una distanza di appena 0,5 millimetri. Il primo "hard disk", denominato "Winchester", aveva una capacit� di 12 Mbyte, mentre oggi i modelli pi� evoluti e dotati di una velocit� di lettura di pochissimi millesimi di secondi, possono raggiungere una "memoria" di 30 Gbyte.

Ormai siamo arrivati alla fatidica data del 1975, forse la pi� importante di tutta la storia dell'informatica. E' l'anno, infatti, in cui due studenti universitari, William "Bill" Gates e Paul Allen, diedero vita a una piccolissima azienda che elaborava linguaggi per "computer": la Microsoft. La sede, inizialmente, fu a Albuquerque, nel New Mexico, ma nel 1980 si trasfer� a Richmond, nello stato di Washington. La fortuna di entrambi pu� essere fatta risalire al linguaggio "Basic" che Gates e Allen programmarono nel 1974 per un "computer" da assemblare in casa, l'"Altair 8800" della Mits e che li mise in luce negli ambienti del "software" . Ma quasi in concomitanza, esattamente nel luglio 1976, a Palo Alto, in California, due giovani dal passato " hippie", Stephen Jobs e Stephen Wozniak, costruirono nel salotto dei genitori adottivi di Jobs l'"Apple I", dando vita all'omonima azienda, battezzata come la casa discografica creata quasi dieci anni prima dai Beatles. Sar� proprio la Apple la grande rivale della Microsoft, soprattutto per il fatto che entrambe hanno usato fin dall'inizio un linguaggio di programmazione completamente diverso. Nel 1977, Jobs e Wozniak costruirono l'"Apple II", un "computer" dotato di un contenitore con tastiera, alimentatore e prese per il collegamento delle "periferiche" presenti sul mercato.

La memoria era appena di 4 Kbyte e come monitor venne utilizzato un televisore domestico e per la memorizzazione dei dati un registratore a cassette, anche se l'anno successivo i modelli vennero equipaggiati con un drive per "floppy disc" . Questo "computer" fu il primo in grado di generare una grafica a colori. Non bisogna dimenticare anche una macchina costruita nel 1980 dall'inglese Clive Sinclair, la "ZX-80", certamente la piccola ed economica, che divenne famosissima tra i pi� giovani dell'epoca. La memoria era di appena 1.024 caratteri (sic!) e per farla funzionare si doveva collegarla a un registratore a cassetta che utilizzava il linguaggio "Basic" e a un televisore per visualizzare le lettere e le immagini. Ma la svolta definitiva, quella che separa il passato dal nostro presente nella storia dei computer � rappresentata da ci� che avvenne il 1981. In quell'anno, la IBM, la maggiore industria informatica del mondo, decise di investire in modo massiccio nei "personal computer", creando in pochi anni una struttura "hardware" e "software" universalmente riconosciuta dalla stragrande maggioranza di costruttori e programmatori. La scelta vincente, indubbiamente, fu quella della scelta del linguaggio programmato. I dirigenti dell'IBM decisero di utilizzare il programma appositamente ideato da Gates e Allen, il celeberrimo MS-DOS (" Microsoft - Disc Operating System" ) con il quale sono cresciuti e hanno appreso i rudimenti dell'informatica milioni di persone.

Da allora sono trascorsi appena 18 anni, ma nel mondo dei "computer" � come se fosse passato pi� di un secolo. Ci� che � stato fatto in questo lasso di tempo, infatti, ha dell'incredibile. Ormai la potenza, la stabilit�, la versatilit� dei vari componenti permettono all'uomo di impiegare i "Personal computer" in ogni circostanza, al punto da considerare la loro presenza e supporto a dir poco indispensabile. Nel giro di pochi anni si avverer� sicuramente quanto ha profetizzato Bill Gates a met� degli anni Settanta, cio� che in ogni casa ci sar� un computer con il quale lavorare, imparare e divertirsi.

Ma, a proposito di futuro, come sar� il "computer" che ci accompagner� nei prossimi decenni? Inutile dire che il presente si sta gi� preparando al futuro informatico, soprattutto nei laboratori del PARC (Palo Alto Research Center), dove alcuni ricercatori, guidati da Mark Weiser, stanno gi� lavorando e sperimentando il "computer" del Duemila. La principale caratteristica di queste apparecchiature sar� data dalla loro "invisibilit�". Con questo termine s'intende una macchina talmente piccola da essere camuffata e nascosta su un essere umano. Una macchina in grado di essere innestata all'interno del nostro corpo e con la quale interagire e comunicare in stato subliminale. Ci� significa che saremo in grado di usare il "computer" non interrompendo altre funzioni o altri compiti. Pi� o meno come succede quando si guida un'automobile. Di fronte a simili possibilit� non bisogna stupirsi pi� di tanto. Ogni anno che passa, infatti, tende a diminuire in modo esponenziale il limite di perfezionamento di queste macchine. La fantasia si sta trasformando sempre pi� in realt�.

RIFERIMENTI BIBLIOGRAFICI

La grande storia del computer, di

Massimo Bozzo - Edizioni Dedalo, Bari 1996

Il grande libro dell'informatica, di Mariagiovanna Sami -

Mondadori editore, 1991

La macchina superintelligente, di Adrian Berry - Longanesi

editore, 1983

di ANDREA BEDETTI

Ringrazio per l'articolo

concessomi gratuitamente

dal direttore di

vedi altri link all'interno di questo sito

a partire dal 1936 per poi proseguire